Teknolojinin ve özellikle de yapay zekanın hızla ilerlemesiyle birlikte, video görüntülerinin manipüle edilmesi her geçen gün daha kolay hale geliyor. Ancak bu gelişmeler, içerik doğrulayıcı araçların manipülasyonları tespit etmesini de zorlaştırıyor.

Video görüntülerinin sahte olduğunu anlamak, özellikle videoları izleyicilere gerçek gibi sunma amacında olanlar için giderek karmaşıklaşıyor. Bu sorunu çözmeye yönelik çalışan bilim insanları, son dönemde önemli bir adım atmış durumda. Cornell Üniversitesi’nden bir ekip, video manipülasyonlarını tespit etmek için yeni bir sistem geliştirdi.

Bu sistem, video görüntülerindeki manipülasyonları tespit etmek için ışık dalgalanmalarına dayalı bir filigran kullanıyor. Eğer bir video üzerinde değişiklik yapılırsa, bu dalgalanmalar sayesinde müdahale kolayca ortaya çıkabiliyor. Bu yenilikçi çözüm, Haziran ayında ACM Transactions on Graphics dergisinde yayımlandı ve geçtiğimiz hafta Vancouver, British Columbia’daki SIGGRAPH 2025 etkinliğinde tanıtıldı.

Cornell Üniversitesi’nden araştırma ekibinin lideri ve projenin ortak yazarı olan Abe Davis, bu buluş hakkında, “Video eskiden gerçekliğin bir kanıtı olarak görülüyordu. Ancak şimdi bu varsayımı yapmamız çok daha zor” diyerek, gelişen teknolojiyle birlikte video içeriğinin güvenilirliğinin sorgulanmaya başlandığını belirtti. Davis, teknolojinin geldiği noktada artık neredeyse her şeyin videoya dönüştürülebileceğini, bu durumun eğlenceli olabilse de gerçeği ayırt etmenin giderek zorlaştığı büyük bir soruna yol açtığını vurguladı.

Araştırmacılara göre, sahte video üreticilerinin bu konuda önemli avantajları bulunuyor. Gerçek görüntülere kolayca erişebilen, gelişmiş ve düşük maliyetli düzenleme araçları kullanabilen bu kişiler, büyük veri setlerinden hızla öğrenebiliyor ve ürettikleri sahte görüntüler neredeyse orijinal görüntülerle ayırt edilemez hale geliyor. Ve bu hızlı gelişim, tespit tekniklerini geride bırakıyor.

Çözüm: “Bilgi Asimetrisi”

Bu durumu ele alan Cornell ekibi, sahte videoları tanımlamak için “bilgi asimetrisi” adı verilen bir yaklaşımın önemli bir rol oynadığını belirtiyor. Bu, sahteciliği yapanların erişemeyeceği özel bilgilere sahip olmayı gerektiriyor. Ancak mevcut dijital filigranlama yöntemlerinin çoğu, bu asimetriden tam anlamıyla yararlanamıyor ve genellikle yetersiz kalıyor. Bazı yöntemler yalnızca belirli bir kameranın kontrolüne ihtiyaç duyarken, bazıları orijinal videoya erişimi şart koşuyor. Örneğin, bir checksum yöntemi dosyanın değişip değişmediğini tespit edebilir, ancak bu değişikliklerin basit bir video sıkıştırması mı yoksa kötü niyetli bir müdahale mi olduğu konusunda bilgi vermez.

Cornell ekibi, daha önce video görüntülerindeki piksellerde yapılan küçük değişikliklerle manipülasyonları tespit etmeyi başarmıştı, ancak bu yöntem yalnızca belirli kamera sistemleri veya yapay zeka modelleriyle sınırlıydı.

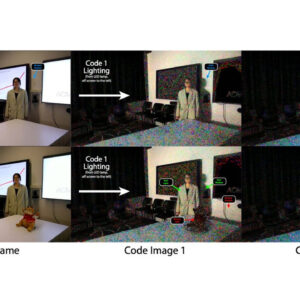

Yeni geliştirilen “gürültü kodlu aydınlatma” (NCI) yöntemi ise bu eksiklikleri gidermek için büyük bir adım atıyor. Bu yöntemde, videolarda kullanılan ışık kaynaklarının gürültü gibi görünen dalgalanmalarına filigran kodları ekleniyor. Bu filigranlar, bilgisayar ekranlarında veya belirli oda aydınlatmalarında görünebilirken, lambalara eklenen minik bir bilgisayar çipi ile de uygulanabiliyor. Davis, “Her filigran, değiştirilmemiş videonun düşük çözünürlüklü, zaman damgalı bir versiyonunu taşır. Biz buna ‘kod video’ diyoruz” şeklinde konuşuyor. Bu kodlar, videoya yapılan herhangi bir müdahaleyi tespit edebilmek için önemli bir araç oluyor. Eğer bir video değiştirilirse, manipüle edilen kısımlar, bu kodlarla çelişmeye başlar ve bu, değişikliklerin nerede yapıldığını ortaya koyar. Ayrıca, yapay zeka ile oluşturulmuş bir sahte video da yalnızca rastgele dalgalanmalar gibi görünecek, bu sayede izleyiciler ve doğrulayıcılar sahte içerikleri daha kolay tespit edebilecek.

Ekip, bu yöntemi videolarda yapılan çeşitli manipülasyon türlerine karşı test etti. Video bükme, hız ve ivme değişiklikleri, montaj gibi birçok manipülasyon türüyle yapılan testlerde, bu filigran yöntemi başarılı oldu. Sistem, insan gözünün algılayamayacağı düzeydeki sinyal değişimlerini tespit edebiliyor. Farklı ten renkleri, kamera hareketleri, nesne hareketleri, flaş ışığı gibi faktörler altında da çalışabiliyor ve hem iç hem de dış mekan çekimlerinde etkinliğini gösterdi. Davis, “Bir saldırgan bu tekniğin kullanıldığını bilse ve kodları çözmeyi başarasa bile, işi hala çok daha zor olacak” dedi ve ekledi: “Çünkü tek bir video için ışığı taklit etmek yerine, her bir kod videosunu ayrı ayrı taklit etmek ve tümünü birbirine uyumlu hale getirmek zorunda kalacak.”

Davis, sahte video sorununu gelecekte daha da büyüyeceğini ve yakın gelecekte çözülmesinin oldukça güç olacağını belirtiyor. Bu durum, dijital manipülasyonların tespit edilmesinin giderek daha önemli ve karmaşık hale geleceğini gösteriyor.